はじめに

ビジネスにおけるAIやデータ活用はDXの文脈の中でこれまでも声高に叫ばれていましたが、利用の手軽さとアウトプット精度の高い生成AIの登場により、その採用企業の数が急速に増加しています。新たな技術を拙速に導入する場合、さまざまなセキュリティ上のリスクが発生する可能性があります。とくに現在の企業のインフラはオンプレミスやクラウド、モバイルやサプライチェーンなどが複雑に絡み合っているため、導入や利用の形態によるリスクの把握とコントロールが必要です。

高まる生成AIへの期待と広がる利用

人工知能(AI)に対する期待と技術開発はこれまで何年も続いてきました。ただし、以前はAIを直接利用するのに数学やプログラミングの知識が必要だったので、多くの人にとって身近な技術とはいきませんでした。ところが近年、自然言語を使って会話するように利用できる生成AIが登場したことで、その利用者数は短期間で爆発的に増加しました。

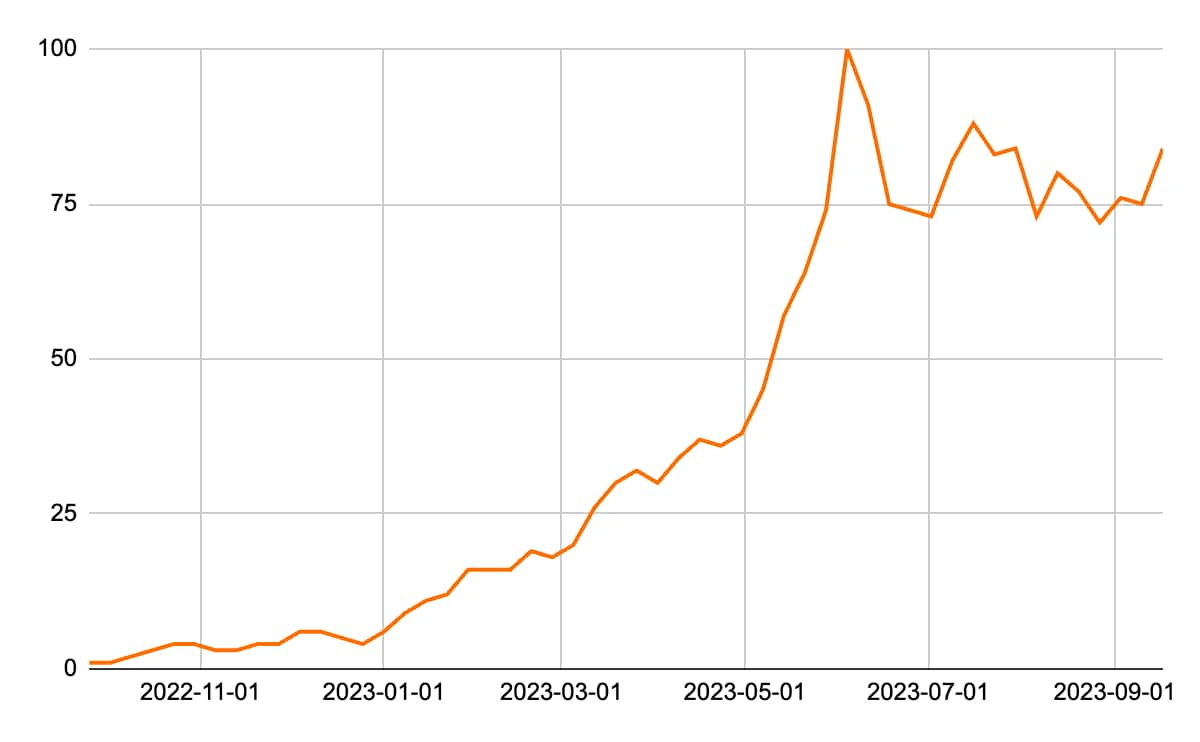

Googleの提供する検索キーワードの傾向や人気度を調査できる Google Trends によれば、「Generative AI (生成AI)」の検索は急増したあと、そのまま高止まりしていることがわかります(図1)。

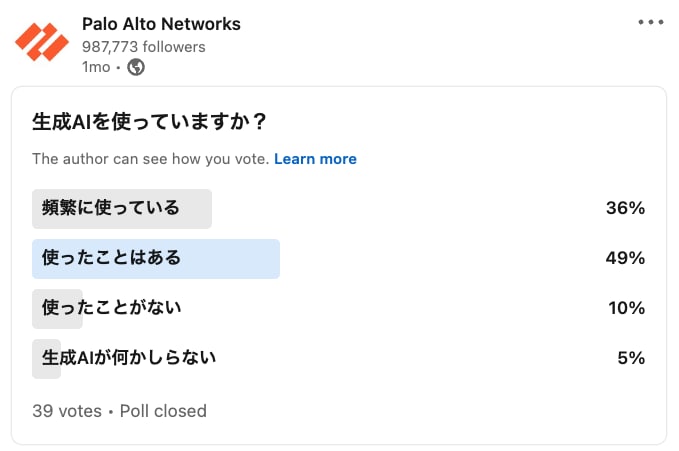

弊社が生成AIの利用についてSNS上で簡易アンケートを実施したところ、回答者の85%が「使用したことがある」と回答しました。ここからも、高い関心を集めているだけでなく、多くの人が実際に利用していることがわかります(図2)。

総務省が2023年7月に公開した「情報通信白書令和5年版」によれば、生成AIの市場規模は2022年は約1.2兆円でしたが、今後は年間成長率35.6%で増加し、2030年には14兆円を超えると予測されています。実際、さまざまな企業や組織から、生成AIを導入し社員や顧客に対して提供するというプレスリリースが数多く出されています。なかでも興味深いのが、新技術の採用にどちらかといえば保守的であると考えられてきた地方自治体などの公的分野が、業務効率化や市民サービス向上のため、生成AIの活用を開始したとアナウンスしはじめていることです。

こうして急速に広がりを見せる生成AIですが、これらのAI技術の利用からサイバーセキュリティリスクは生じないでしょうか。生じるなら、それはどのようなものでしょうか。

AI利用の代表的な3つのユースケースとセキュリティリスク

AI技術のもたらすサイバーセキュリティリスクを検討するまえに、そもそもAIはどのように利用されることが多いのか、その方法を考えてみます。本稿では代表的な3つのユースケースをとりあげました。

外部AIシステムの利用

AIサービス事業者が提供するシステムにWebやAPI経由でアクセスし、利用するケースです。アカウントを開設すればすぐ利用できて手軽である反面、事前に事業者が用意したデータしか使えないので、必ずしも利用側に特有の状況や意図を汲んだ精度の高いアウトプットが得られない場合があります。

一般的なSaaSと同様、利用者の責任は主に「アクセスする経路」と「データの保護」にあります。利用するアカウントのIDやパスワードが脆弱であったり、フィッシング攻撃によって漏えいすると、そのアカウントが攻撃者に悪用されます。また、データの保護にも多くの注意を払う必要があります。とくに生成AIでは自然言語で会話してデータをやりとりするので、利用者が「この会話は保護すべきデータである」と認識しづらい場合があります。AI事業者によっては、こうした会話で入力した情報を学習データとして再利用することがあるので、入力された個人情報やソースコードなど組織の機密情報がサービスを通じて漏えいするリスクもあります。このため、生成AIとの会話の内容には注意を払う必要があります。

外部AIシステムに独自データを追加

AIサービス事業者が提供する事前学習データに自社固有のデータを加えてファインチューニングすることで、より精度の高いアウトプットを求める方式です。国内で急速に増えている導入事例はこのケースです。

先の外部AIシステムを利用するケースと似ていますが、いくつかの点で注意が必要です。まず、精度の高いアウトプットを得るには質の高いインプットが必要です。組織固有で質の高いデータを一定量収集すると、機微な情報が一箇所に集まる可能性があります。このため、窃取・破壊・改ざん・漏えいなどのリスクに備える必要があります。

次に、収集データを外部AIシステムにアップロードして利用する場合、その外部でのデータの保護について、利用者の責任範囲を確認する必要があります。IaaS上に設置したストレージにデータをアップロードして保存する必要がある場合、利用者にはより多くのセキュリティ上の責任が課せられます。したがって、システムの構成や設定、監視を徹底する必要があります。

内製AIシステムの利用

AIシステムを内製すれば、アルゴリズムやモデル、データを含め、自組織でシステムを完全にコントロールできます。その反面、必要なセキュリティは先の2つのユースケースより多くなります。

本稿ではデータとシステムの2点を取り上げます。

AIシステムでは、学習データの収集・保管が行われます。このため、窃取・破壊・改ざんのターゲットになりやすいのは先のユースケースと同様です。加えて、顧客や取引先またはインターネットから収集した外部データを利用する場合、不正なデータ(たとえば悪意のあるデータ、倫理や著作権上の問題があるデータ)が含まれるケースが考えられます。このため、自社の基準から外れたデータが含まれないよう、監視する必要があります。

AIシステムを内製する場合、自社か委託先で開発を行います。そのさい、さまざまなオープンソースまたはサードパーティのソフトウェア(自社以外の第三者が書いたコード)を多数、システムで利用することになります。このなかには悪意のあるコードや脆弱性がまぎれこむ可能性があるので、ソフトウェアサプライチェーンを含めた開発環境のセキュリティ対策が必要となります。

さいごに

一年前にはさほど話題にのぼらなかった技術を多くの企業・組織が急速に活用しはじめることは、ITの歴史のなかでも稀なことです。今後もさらに多くの事業者が参入し、技術開発が進み、新たなサービスやニーズが生まれ、AIはビジネスに不可欠な存在となっていくことでしょう。

一方で、AIシステムとデータに対するビジネスの依存度が高まると、その停止や破壊から組織が受ける影響も甚大になります。また、生成AIのように誰でも簡単に利用できる技術には利用者のリテラシーが求められるため、教育や技術によるセーフガードが有効です。AIに限らず、リスクを適切にコントロールしながら、技術をうまく活用していくバランスが求められています。